Garantir la sécurité des données lors de l'utilisation de solutions d'IA

Qu'il s'agisse de recommandations de produits personnalisées ou d'alimentation de véhicules autonomes, l'intelligence artificielle transforme rapidement les industries, stimule les innovations et façonne notre vie quotidienne. Mais l'IA n'est pas aussi autonome qu'il n'y paraît, et ses capacités ne sont aussi bonnes que son accès aux données.

À mesure que les systèmes d'IA générative deviennent de plus en plus sophistiqués et gourmands en données, ils s'appuient sur de grandes quantités de données sensibles non structurées, des données clients aux rapports internes, pour fonctionner efficacement. Cela augmente le risque d'utilisation abusive, d'exposition ou de violation, ce qui rend la sécurité robuste des données non seulement importante, mais essentielle pour une adoption sûre et responsable de l'IA.

Sondages récents montrent que 96 % des organisations mettent en place une gouvernance pour l'IA générative, et 82 % s'inquiètent des fuites de données provenant de ces outils. Pour les chefs d'entreprise, la question est de savoir comment adopter les outils d'IA dans leurs processus métier sans exposer les secrets d'entreprise, les données confidentielles ou les informations des clients.

Comment les solutions d'IA peuvent compromettre la sécurité des données

Garantir la sécurité des données lors de l'utilisation de l'IA ne consiste pas seulement à prévenir les violations, il s'agit également de comprendre comment des informations sensibles peuvent être divulguées involontairement dans le cadre d'une utilisation quotidienne. À mesure que l'IA est intégrée aux flux de travail des entreprises, des risques apparaissent non seulement lors du développement et du déploiement, mais également en ce qui concerne la manière dont les employés interagissent avec ces outils et la manière dont les systèmes d'IA sont structurés pour apprendre et réagir.

Par exemple, un employé peut coller des chiffres confidentiels, des informations clients ou du code source dans un outil d'IA génératif pour obtenir une analyse rapide, sans savoir que ces données peuvent être stockées, traitées ou réutilisées de manière indépendante de sa volonté. Dans le même temps, les modèles d'IA eux-mêmes peuvent parfois conserver et reproduire des fragments de données d'entraînement sensibles. Il ne s'agit pas de cas extrêmes, mais de risques systémiques liés à une utilisation normale en l'absence de mesures de protection appropriées.

Contrairement aux cyberattaques traditionnelles, ces fuites se produisent souvent sans que personne ne s'en rende compte. Un récent Rapport Gartner souligne que, sans protocoles stricts, les chatbots IA peuvent exposer par inadvertance des données privées stockées dans les systèmes de l'entreprise. C'est pourquoi la sécurisation de l'IA commence par l'intégration de politiques claires, de contrôles d'accès et d'une surveillance de la manière dont ces outils sont adoptés au sein de l'organisation.

Contrairement à la sécurité des données traditionnelle, qui se concentre sur la sauvegarde des ensembles de données statiques, la sécurité des données basées sur l'IA doit relever des défis uniques :

- Exigences en matière de volume de données élevé: Les modèles d'IA s'appuient sur des données à grande échelle, ce qui augmente la surface de fuite potentielle.

- Sources de données non vérifiées: Les données utilisées par l'IA proviennent généralement de sources multiples, qui ne sont parfois pas vérifiées, ce qui complique les efforts de sécurité.

- Menaces contradictoires: les entrées malveillantes peuvent manipuler les modèles d'IA, ce qui entraîne des sorties incorrectes ou des systèmes compromis.

- Surface d'attaque étendue: La complexité des systèmes d'IA, notamment des modèles, des API et de l'infrastructure cloud, crée davantage de points d'entrée pour les attaquants.

Ensemble, ces facteurs exigent un changement dans la façon dont les organisations abordent la sécurité des données lorsqu'elles utilisent l'IA. Cela implique des stratégies robustes qui garantissent l'intégrité et la confidentialité des données et la conformité à des réglementations telles que le Règlement général sur la protection des données (RGPD) et la California Consumer Privacy Act (CCPA). Des incidents du monde réel, tels que le exposition de 38 To de données Microsoft par des chercheurs en IA, mettent en lumière les enjeux.

5 pratiques pour atténuer les risques liés aux données lors de l'intégration de l'IA

Les problèmes de sécurité des données ne doivent pas être considérés comme une raison pour éviter d'utiliser l'IA, mais plutôt comme une raison pour l'utiliser à bon escient. L'adoption de l'IA devenant inévitable dans toutes les fonctions de l'entreprise, l'objectif n'est pas de ralentir l'innovation, mais de l'intégrer de manière responsable. En prenant des mesures proactives pour sécuriser les informations sensibles, les entreprises peuvent exploiter tout le potentiel des outils d'IA, sans s'exposer à des risques inutiles. Voici cinq pratiques fondamentales qui vous aideront à mettre en œuvre l'IA en toute sécurité et à grande échelle.

- Mettre en place un cadre clair de gouvernance des données d'IA

Définissez la propriété, les politiques et les flux de travail pour chaque projet d'IA. Classez les données par sensibilité et cartographiez qui peut y accéder, dans quelles circonstances et via quels points de terminaison d'IA approuvés. L'intégration de la gouvernance de l'IA à votre programme de gouvernance des données existant garantit que chaque bot, modèle ou API que vous déployez s'aligne sur vos mandats généraux en matière de sécurité des données. - Tirez parti des contrôles techniques et de la surveillance

Chiffrez toutes les données en transit et au repos, appliquez un accès basé sur les rôles pour les outils d'IA et utilisez des passerelles API pour centraliser et enregistrer chaque interaction d'IA. Mettez en œuvre une analyse en temps réel des instructions et des sorties pour les mots clés sensibles ou les informations personnelles identifiables (PII), et exécutez périodiquement des exercices « en équipe rouge » pour détecter les fuites. En associant le chiffrement, les contrôles d'accès et la surveillance automatisée, vous créez une défense résiliente contre les fuites accidentelles de données et les attaques par sondage contradictoire. - Contrôlez et gérez les fournisseurs d'IA tiers

Traitez n'importe quel service d'IA externe comme vous le feriez pour un fournisseur de cloud essentiel. Ajoutez la certification SOC 2 ou ISO 27001 comme exigence, insistez sur les garanties contractuelles selon lesquelles les entrées des clients ne seront pas utilisées pour recycler les modèles et préférez les déploiements de niveau entreprise ou sur site qui ne partagent jamais vos données avec des systèmes publics. Les risques liés à l'IA fantôme disparaissent lorsque vous proposez des alternatives sûres et approuvées et que vous appliquez l'authentification unique (SSO) ou des restrictions réseau. - Intégrez des technologies améliorant la confidentialité

Dans la mesure du possible, choisissez des solutions d'IA qui prennent en charge la confidentialité différentielle, l'anonymisation des données ou l'apprentissage fédéré. Ces techniques brouillent le lien entre les requêtes et les données d'origine, réduisant ainsi l'efficacité des attaques par inversion de modèle ou par inférence d'adhésion, et contribuant à garantir une conformité continue au RGPD, à la CCPA ou à toute autre forme de conformité. - Intégrez l'IA à vos programmes de gestion des risques et de conformité

Élargissez les évaluations des risques de votre entreprise et vos plans de réponse aux incidents pour couvrir des scénarios spécifiques à l'IA. Documentez chaque flux de données entrant et sortant de vos systèmes d'IA, effectuez des analyses d'impact sur la protection des données pour les cas d'utilisation à haut risque et formez votre équipe de réponse aux incidents à la gestion des violations liées à l'IA parallèlement aux cyberévénements traditionnels.

Comment une solution iPaaS permet d'intégrer l'IA en toute sécurité

Lorsque les entreprises adoptent des outils d'IA pour améliorer leurs flux de travail, qu'il s'agisse de l'automatisation du service client ou des prévisions de la chaîne d'approvisionnement, elles se heurtent souvent à un défi majeur : comment connecter ces outils aux systèmes internes et aux sources de données sans compromettre les informations sensibles. C'est là que les solutions iPaaS (plateforme d'intégration en tant que service) simplifient considérablement les intégrations d'IA et la sécurité des données.

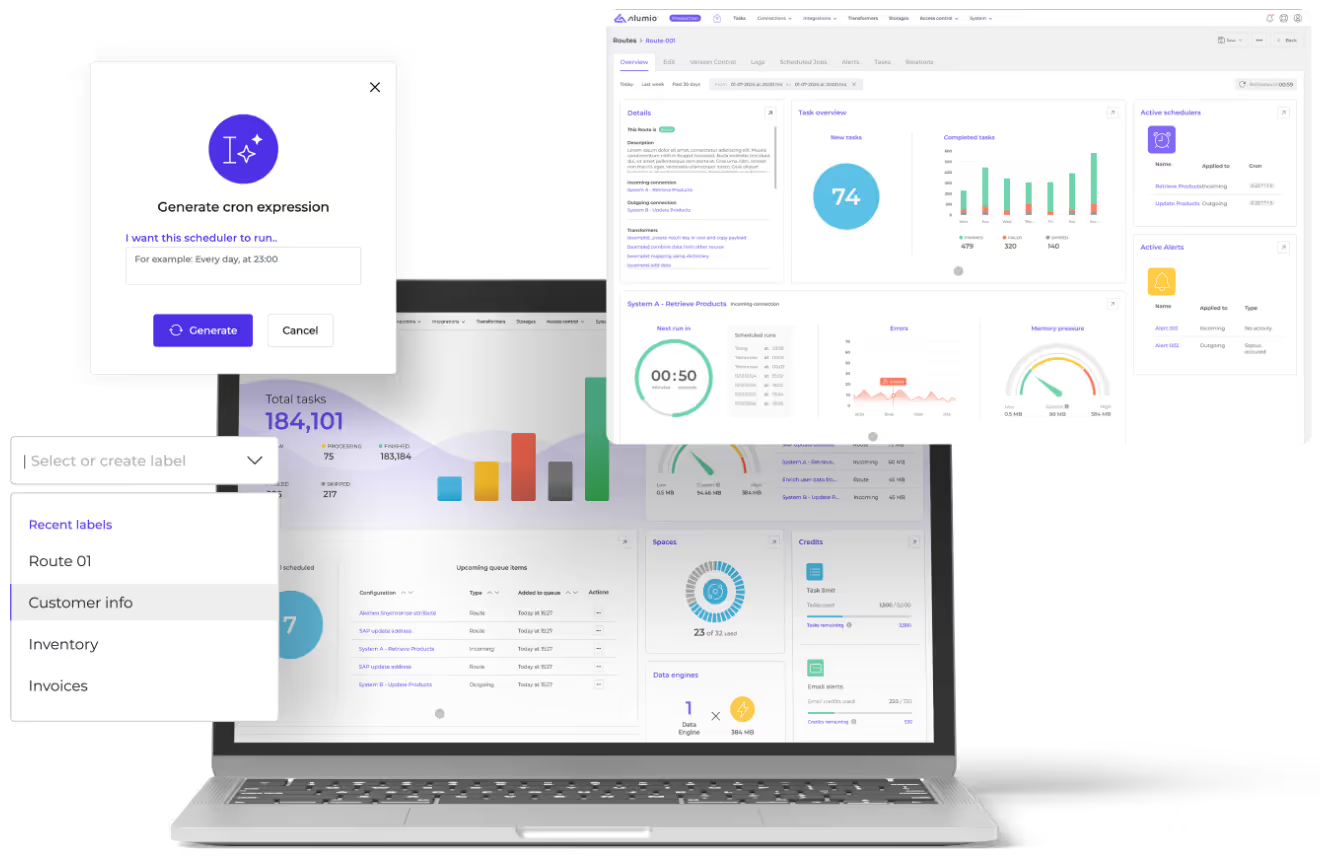

Alumio est une iPaaS, ou plateforme d'intégration native du cloud, pilotée par API, conçue pour connecter les systèmes, transformer les données et automatiser les flux de travail dans votre environnement informatique. Il permet aux organisations de sécuriser connectez des outils d'IA comme OpenAI aux systèmes ERP, aux plateformes de commerce électronique, aux CRM et aux bases de données, sans écrire de code personnalisé ni exposer de données brutes.

Lors de l'intégration de l'IA, une solution iPaaS ISO 27001 telle qu'Alumio est déjà dotée de plusieurs mesures de sécurité des données intégrées cruciales qui contribuent à réduire les risques liés à l'utilisation de l'IA de la manière suivante :

- Contrôlez l'accès aux données en utilisant l'iPaaS comme couche sécurisée entre les outils d'IA et vos systèmes principaux. Seules les données approuvées et pertinentes sont transmises, avec des autorisations précises et des filtres basés sur les rôles appliqués avant toute exposition.

- Surveiller et enregistrer les données dans chaque transaction de données, garantissant la traçabilité et l'auditabilité de chaque invite, entrée ou réponse passant par un flux de travail connecté à l'IA.

- Centralisez les connexions API pour obtenir une visibilité complète sur les données qui sont partagées, avec qui et à quel moment, réduisant ainsi le risque d'outils parallèles ou d'accès non autorisé.

- Appliquez une authentification de niveau entreprise (SSO, gestion des jetons, clés cryptées) afin que les outils d'IA ne puissent accéder aux données et aux systèmes que dans la mesure autorisée.

- Automatisez les contrôles de conformité en intégrant des étapes de validation dans les itinéraires de données pour garantir que chaque intégration répond aux normes réglementaires et internes.

En bref, l'iPaaS d'Alumio fournit l'infrastructure nécessaire pour connecter les outils d'IA de manière sécurisée et responsable, afin que vos équipes puissent automatiser et innover, sans mettre en danger la conformité ou les données sensibles.

Intégrer la sécurité dans l'ADN de l'intégration de l'IA

Pour rendre la sécurité des données efficace à l'ère de l'IA, il faut intégrer des mesures de protection à chaque phase d'adoption, qu'il s'agisse de la manière dont les outils d'IA sont choisis, de leur intégration ou de leur utilisation quotidienne par les équipes. Il ne s'agit pas seulement de se défendre contre les menaces externes telles que les violations ou les attaques contradictoires, il s'agit de créer des systèmes responsables de l'intérieur vers l'extérieur. Cela commence par des politiques claires : définissez quelles données peuvent être partagées avec les outils d'IA, sensibilisez les équipes aux habitudes de communication sécurisées et appliquez des directives strictes concernant la manière dont les modèles publics ou tiers sont accessibles.

Ensuite, superposez les bons contrôles techniques. Classifiez les données sensibles, appliquez le chiffrement, limitez l'accès à l'IA en fonction des rôles et mettez en œuvre des outils pour surveiller les invites et signaler les données personnelles ou propriétaires exposées. Plus important encore, sélectionnez des outils d'IA et des solutions d'intégration, comme l'iPaaS Alumio, qui donnent la priorité à une sécurité de niveau entreprise. En mettant en œuvre une gouvernance solide, des garanties techniques et des flux de travail d'IA approuvés, les entreprises peuvent exploiter tout le potentiel de l'IA, sans compromettre la conformité, la confiance des clients ou la propriété intellectuelle.