Habilitar la seguridad de los datos al usar soluciones de IA

Desde recomendaciones de productos personalizadas hasta la alimentación de vehículos autónomos, la inteligencia artificial está transformando rápidamente las industrias, impulsando innovaciones y dando forma a nuestra vida diaria. Sin embargo, la IA no es tan autosuficiente como parece, y sus capacidades son tan buenas como su acceso a los datos.

A medida que los sistemas de IA generativa se vuelven más sofisticados y consumen más datos, dependen de grandes cantidades de datos confidenciales no estructurados, desde datos de clientes hasta informes internos, para funcionar de manera eficaz. Esto aumenta el riesgo de uso indebido, exposición o infracciones, lo que hace que la seguridad sólida de los datos no solo sea importante, sino también esencial para adoptar la IA de forma segura y responsable.

Encuestas recientes muestran que el 96% de las organizaciones están creando una gobernanza para la IA generativa, y el 82% se preocupa por la filtración de datos de estas herramientas. Para los líderes empresariales, la pregunta es cómo adoptar las herramientas de inteligencia artificial en sus procesos empresariales sin exponer los secretos corporativos, los datos confidenciales o la información de los clientes.

Cómo las soluciones de IA pueden comprometer la seguridad de los datos

Garantizar la seguridad de los datos al usar la IA no consiste solo en prevenir las infracciones, sino también en comprender cómo la información confidencial puede filtrarse involuntariamente a través del uso diario. A medida que la IA se incorpora a los flujos de trabajo empresariales, surgen riesgos no solo durante el desarrollo y la implementación, sino también en la forma en que los empleados interactúan con estas herramientas y en la forma en que los sistemas de IA están estructurados para aprender y responder.

Por ejemplo, un empleado puede pegar cifras confidenciales, información de clientes o código fuente en una herramienta de IA generativa para obtener un análisis rápido, sin saber que estos datos podrían almacenarse, procesarse o reutilizarse fuera de su control. Mientras tanto, los propios modelos de IA a veces pueden retener y reproducir fragmentos de datos de entrenamiento confidenciales. No se trata de casos extremos, sino de riesgos sistémicos derivados del uso normal en ausencia de las medidas de protección adecuadas.

A diferencia de los ciberataques tradicionales, estas filtraciones suelen ocurrir sin que nadie se dé cuenta. Un reciente Informe de Gartner destaca que, sin protocolos estrictos, los chatbots de IA pueden exponer inadvertidamente los datos privados almacenados en los sistemas empresariales. Por eso, para proteger la IA hay que empezar por incorporar políticas, controles de acceso y supervisión claros a la hora de adoptar estas herramientas en toda la organización.

A diferencia de la seguridad de datos tradicional, que se centra en proteger los conjuntos de datos estáticos, la seguridad de los datos de la IA debe abordar desafíos únicos:

- Requisitos de alto volumen de datos: Los modelos de IA se basan en datos a gran escala, lo que aumenta el área de superficie para posibles fugas.

- Fuentes de datos no verificadas: Los datos utilizados por la IA suelen provenir de varias fuentes, que a veces no se verifican, lo que complica las iniciativas de seguridad.

- Amenazas contradictorias: Las entradas malintencionadas pueden manipular los modelos de IA y generar salidas incorrectas o comprometer los sistemas.

- Superficie de ataque ampliada: La complejidad de los sistemas de IA, incluidos los modelos, las API y la infraestructura en la nube, crea más puntos de entrada para los atacantes.

En conjunto, estos factores exigen un cambio en la forma en que las organizaciones abordan la seguridad de los datos cuando utilizan la IA. Implica estrategias sólidas que garanticen la integridad de los datos, la confidencialidad y el cumplimiento de normativas como el Reglamento General de Protección de Datos (GDPR) y la Ley de Privacidad del Consumidor de California (CCPA). Incidentes del mundo real, como el exposición de 38 TB de datos de Microsoft de investigadores de IA, destacan lo que está en juego.

5 prácticas para mitigar los riesgos de los datos al integrar la IA

Los problemas de seguridad de los datos no deben considerarse una razón para evitar el uso de la IA, sino una razón para usarla con prudencia. A medida que la adopción de la IA se hace inevitable en todas las funciones empresariales, el objetivo no es frenar la innovación, sino integrarla de manera responsable. Al tomar medidas proactivas para proteger la información confidencial, las empresas pueden aprovechar todo el potencial de las herramientas de inteligencia artificial sin exponerse a riesgos innecesarios. Estas son cinco prácticas fundamentales que le ayudarán a implementar la IA de forma segura y a escala.

- Establezca un marco claro de gobierno de datos de IA

Defina la propiedad, las políticas y los flujos de trabajo en torno a cada proyecto de IA. Clasifique los datos según su nivel de sensibilidad y determine quién puede acceder a ellos, en qué circunstancias y a través de qué puntos finales de IA aprobados. La integración de la gobernanza de la IA en su programa de gobierno de datos existente garantiza que cada bot, modelo o API que implemente se alinee con sus mandatos más amplios de seguridad de datos. - Aproveche los controles técnicos y la supervisión

Cifre todos los datos en tránsito y en reposo, imponga el acceso basado en roles para las herramientas de IA y use las pasarelas de API para centralizar y registrar cada interacción de la IA. Escanee en tiempo real las solicitudes y los resultados en busca de palabras clave confidenciales o información de identificación personal (PII) y lleve a cabo ejercicios periódicos «en equipo» para comprobar si hay filtraciones. Al combinar el cifrado, los controles de acceso y la supervisión automatizada, se crea una defensa sólida contra los derrames de datos accidentales y los ataques de sondeo contradictorios. - Examine y administre proveedores de IA de terceros

Trate cualquier servicio de IA externo como lo haría con un proveedor de nube esencial. Añada como requisito la certificación SOC 2 o la ISO 27001, insista en que los contratos garanticen que las aportaciones de los clientes no se utilizarán para volver a entrenar modelos y prefiera las implementaciones de nivel empresarial o locales que nunca compartan sus datos con sistemas públicos. Los riesgos de la IA en la sombra desaparecen cuando se ofrecen alternativas seguras y aprobadas y se imponen restricciones de red o de inicio de sesión único (SSO). - Incorpore tecnologías que mejoren la privacidad

Siempre que sea posible, elija soluciones de IA que admitan la privacidad diferencial, la anonimización de datos o el aprendizaje federado. Estas técnicas difuminan el vínculo entre las consultas y los datos originales, lo que reduce la eficacia de los ataques de inversión de modelos o inferencia de membresía y ayuda a garantizar el cumplimiento continuo del RGPD, la CCPA u otros tipos de cumplimiento. - Integre la IA en sus programas de riesgo y cumplimiento

Amplíe las evaluaciones de riesgos empresariales y los planes de respuesta a incidentes para cubrir escenarios específicos de la IA. Documente todos los flujos de datos que entran y salen de sus sistemas de IA, lleve a cabo evaluaciones del impacto de la protección de datos en casos de uso de alto riesgo y capacite a su equipo de respuesta a incidentes para gestionar las infracciones relacionadas con la IA junto con los cibereventos tradicionales.

Cómo una solución iPaaS ayuda a integrar la IA de forma segura

A medida que las empresas adoptan herramientas de inteligencia artificial para mejorar los flujos de trabajo, desde la automatización del servicio al cliente hasta la previsión de la cadena de suministro, a menudo se enfrentan a un desafío fundamental: cómo conectar estas herramientas a los sistemas internos y las fuentes de datos sin comprometer la información confidencial. Aquí es donde las soluciones iPaaS (plataforma de integración como servicio) simplifican considerablemente las integraciones de la IA y la seguridad de los datos.

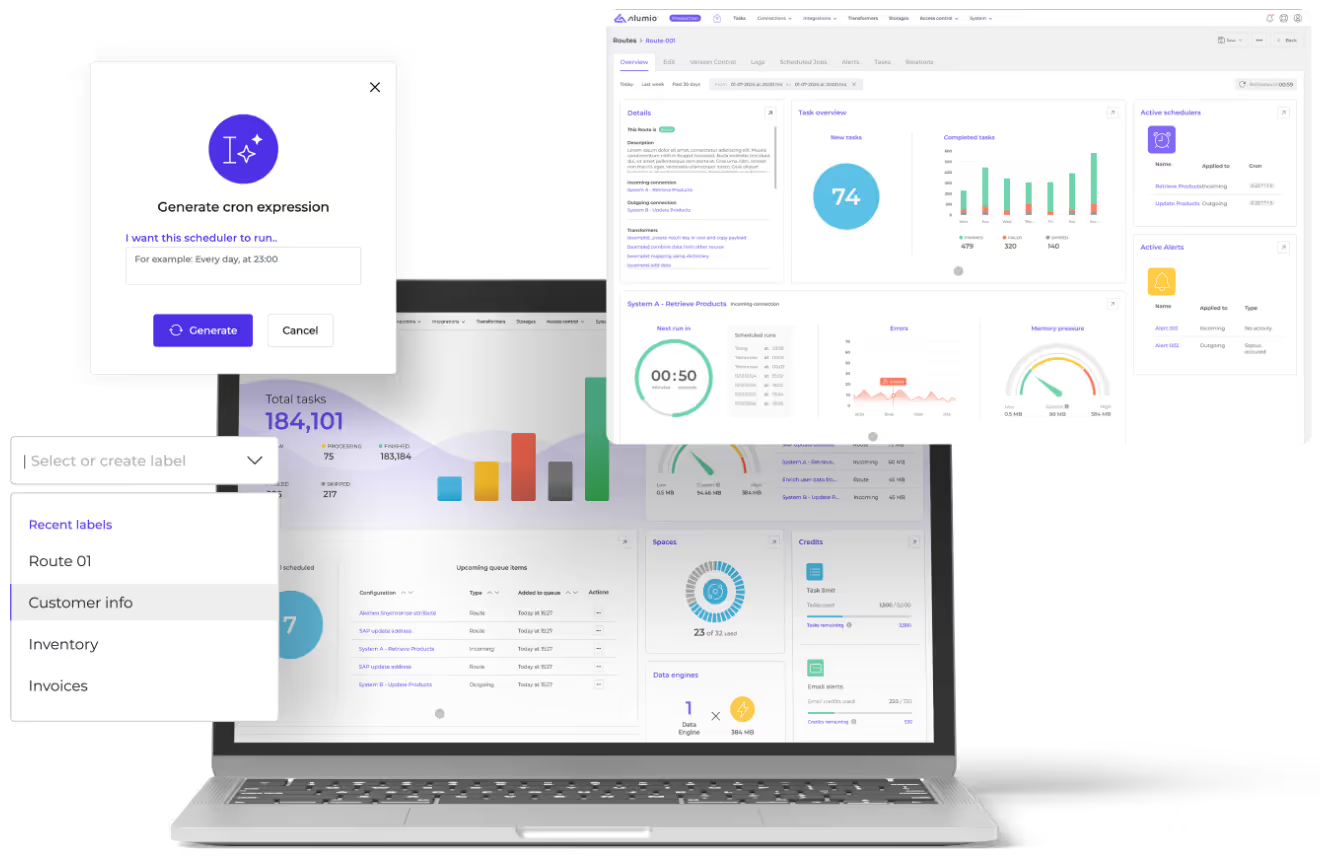

Alumio es una iPaaS o plataforma de integración nativa de la nube impulsada por API, diseñada para conectar sistemas, transformar datos y automatizar los flujos de trabajo en todo su entorno de TI. Permite a las organizaciones hacer lo siguiente de forma segura conecta herramientas de IA como OpenAI a sistemas ERP, plataformas de comercio electrónico, CRM y bases de datos, sin escribir código personalizado ni exponer datos sin procesar.

Al integrar la IA, una solución iPaaS ISO 27001 como Alumio ya viene con varias medidas de seguridad de datos cruciales incorporadas que ayudan a reducir los riesgos de datos derivados del uso de la IA de las siguientes maneras:

- Controle el acceso a los datos mediante el uso de la iPaaS como una capa segura entre las herramientas de IA y sus sistemas principales. Solo se transmiten los datos aprobados y relevantes, y se aplican permisos detallados y filtros basados en funciones antes de cualquier exposición.

- Supervise y registre los datos en cada transacción de datos, garantizando la trazabilidad y la auditabilidad de cada aviso, entrada o respuesta que pase por un flujo de trabajo conectado a la IA.

- Centralice las conexiones de API para obtener una visibilidad total de qué datos se comparten, con quién y cuándo, lo que reduce el riesgo de herramientas ocultas o de accesos no autorizados.

- Implemente la autenticación de nivel empresarial (SSO, administración de tokens, claves cifradas) para que las herramientas de IA solo puedan acceder a los datos y sistemas según lo permitido.

- Automatice los controles de cumplimiento incorporando pasos de validación en las rutas de datos para garantizar que cada integración cumpla con los estándares normativos e internos.

En resumen, Alumio iPaaS proporciona la infraestructura para conectar las herramientas de IA de forma segura y responsable, de modo que sus equipos puedan automatizar e innovar, sin poner en riesgo el cumplimiento o los datos confidenciales.

Incorporar la seguridad en el ADN de la integración de la IA

Hacer que la seguridad de los datos sea efectiva en la era de la IA significa incorporar medidas de seguridad en cada fase de la adopción, desde la forma en que se eligen las herramientas de IA hasta la forma en que se integran y la forma en que se utilizan a diario en los equipos. No se trata solo de defenderse de las amenazas externas, como las brechas de seguridad o los ataques adversarios, sino de crear sistemas responsables desde adentro hacia afuera. Esto comienza con políticas claras: defina qué datos se pueden compartir con las herramientas de inteligencia artificial, eduque a los equipos sobre hábitos de envío seguros y aplique directrices estrictas sobre cómo acceder a los modelos públicos o de terceros.

Luego, coloca los controles técnicos correctos. Clasifique los datos confidenciales, aplique el cifrado, restrinja el acceso a la IA en función de las funciones e implemente herramientas para supervisar las indicaciones y marcar los datos personales o privados expuestos. Y lo que es más importante, seleccione herramientas de inteligencia artificial y soluciones de integración, como la iPaaS de Alumio, que prioricen la seguridad de nivel empresarial. Al implementar una gobernanza sólida, salvaguardias técnicas y flujos de trabajo de IA comprobados, las empresas pueden aprovechar todo el potencial de la IA sin comprometer el cumplimiento, la confianza de los clientes o la propiedad intelectual.